python机器学习之手写K-means算法

本文共 2725 字,大约阅读时间需要 9 分钟。

上一期的机器学习算法更新到岭回归,然后看完了非监督的聚类算法就进入到深度学习了,机器学习剩下几章没更新,这几天上课时候老师讲到Kmeans算法,于是我就觉得手写一下Kmeans算法,加深对聚类算法的理解。

1. K-means算法原理

K-means算法的思想:

- 首先从数据集中随机选取K个点作为初始中心点。

- 然后分别计算所有点到这K个点的距离,每个点选取距离最小的中心点将他们归成一类。

- 重现计算各个类中所有点的平均值,选出新的中心点

- 再次计算所有点到新的中心的距离,然后归类。

- 循环多次,当中心点变动较小或不变时,算法结束。

2. 算法实现

- 初始化初始点,计算距离的函数,分类的函数

def distance(a,b):#计算两点之间的欧式距离 dis=np.sqrt(((a[0]-b[0])**2)+((a[1]-b[1])**2)) return disdef initCenterpoint(k):#用随机数生成K个2维的初始中心点 return np.random.random(k*2).reshape(k,2)def owner(dot,centerpoint):#属于哪个簇 kclass=0 min_distance = np.inf#距离初始化为无限大 for i in range(len(centerpoint)):#分别计算各个点与中心点的距离,选取最小的距离的中心点作为分类 d=distance(dot,centerpoint[i]) if d

- 计算每个类的中心点

def newCenter2(point,new_kclass):#求每组的平均值以确定中心 k=max(new_kclass)+1#比如Kclass分类为(0,1,2)则K的取值为3 newCenter=np.zeros((k,2))#初始化一个(K,3)的矩阵,用来存放分类类别 point=pd.DataFrame(point,columns=["x","y"])#点的数据转化为dataframe new_kclass=pd.DataFrame(new_kclass,columns=["kcalss"])#类别信息转化为dataframe类型 point2=point.join(new_kclass)#合并点的信息和点的分类信息 point2.columns=["x","y","kclass"]#将新的dataframe重新命名 for i in range(k):#分别计算类别为0,1的平均值,保存为一个(K,2)的二维数组 point3=point2[point2["kclass"]==i] newCenter[i]=point3[["x","y"]].mean(axis=0) return newCenter

- 将计算出每个点的所属类整合成一个一维数组

def update_kcalss(point,centerpoint):#将获得的每个点的所属类的信息放在一个数组里 n=len(point)#点的个数为数组的长度 new_kclass = np.zeros((n)) for i,point in enumerate(point):#利用循环给数组添加数 new_kclass[i]=owner(point,centerpoint) new_kclass=new_kclass.astype(int) return new_kclass#返回数组

- 组合成K-means算法

def kmeans(point): centerpoint=initCenterpoint(2)#初始化K个类别,我这里是2个 kclass=update_kcalss(point,centerpoint)#初始化每个点所属的类别 old_kclsss = kclass#保留第一次的所属类别 for i in range(200):#循环一个很大次数 centerpoint=newCenter2(point,kclass)#更新新的中心点 kclass=update_kcalss(point,centerpoint)#计算新的类别 if np.array_equal(old_kclsss,kclass):#利用新的类别和旧类别进行比较,如果不同,说明分类没有结束,如果相同,分类结束。 print("循环多少次:",i) break else: old_kclsss=kclass return centerpoint,kclass#返回中心点和分类类别 - 测试一下

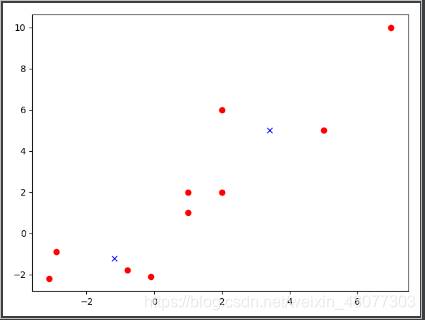

#将c进行聚类c = np.array([[1,2],[1,1],[2,2],[5,5],[-0.10,-2.10],[-0.8,-1.8],[-2.9,-0.9],[-3.1,-2.2],[2,6],[7,10]])a,b=kmeans(c)c2=pd.DataFrame(c)plt.plot(c2[0],c2[1],"or")print(b)a1=pd.DataFrame(a)print(a1)plt.plot(a1[0],a1[1],"xb")plt.show()

- 结果

3.全部代码

import numpy as npimport pandas as pdfrom matplotlib import pyplot as plt#二维数据Kmeans算法def distance(a,b):#计算两点之间的欧式距离 dis=np.sqrt(((a[0]-b[0])**2)+((a[1]-b[1])**2)) return disdef initCenterpoint(k):#用随机数生成K个2维的初始中心点 return np.random.random(k*2).reshape(k,2)def owner(dot,centerpoint):#属于哪个簇 kclass=0 min_distance = np.inf for i in range(len(centerpoint)): d=distance(dot,centerpoint[i]) if d

转载地址:http://hjpv.baihongyu.com/

你可能感兴趣的文章

NIFI1.21.0_java.net.SocketException:_Too many open files 打开的文件太多_实际操作---大数据之Nifi工作笔记0051

查看>>

NIFI1.21.0_Mysql到Mysql增量CDC同步中_日期类型_以及null数据同步处理补充---大数据之Nifi工作笔记0057

查看>>

NIFI1.21.0_Mysql到Mysql增量CDC同步中_补充_更新时如果目标表中不存在记录就改为插入数据_Postgresql_Hbase也适用---大数据之Nifi工作笔记0059

查看>>

NIFI1.21.0_NIFI和hadoop蹦了_200G集群磁盘又满了_Jps看不到进程了_Unable to write in /tmp. Aborting----大数据之Nifi工作笔记0052

查看>>

NIFI1.21.0_Postgresql和Mysql同时指定库_指定多表_全量同步到Mysql数据库以及Hbase数据库中---大数据之Nifi工作笔记0060

查看>>

NIFI1.21.0最新版本安装_连接phoenix_单机版_Https登录_什么都没改换了最新版本的NIFI可以连接了_气人_实现插入数据到Hbase_实际操作---大数据之Nifi工作笔记0050

查看>>

NIFI1.21.0最新版本安装_配置使用HTTP登录_默认是用HTTPS登录的_Https登录需要输入用户名密码_HTTP不需要---大数据之Nifi工作笔记0051

查看>>

NIFI1.21.0通过Postgresql11的CDC逻辑复制槽实现_指定表多表增量同步_增删改数据分发及删除数据实时同步_通过分页解决变更记录过大问题_02----大数据之Nifi工作笔记0054

查看>>

NIFI1.21.0通过Postgresql11的CDC逻辑复制槽实现_指定表多表增量同步_增加修改实时同步_使用JsonPath及自定义Python脚本_03---大数据之Nifi工作笔记0055

查看>>

NIFI1.21.0通过Postgresql11的CDC逻辑复制槽实现_指定表多表增量同步_插入修改删除增量数据实时同步_通过分页解决变更记录过大问题_01----大数据之Nifi工作笔记0053

查看>>

NIFI1.21.0通过Postgresql11的CDC逻辑复制槽实现_指定表或全表增量同步_实现指定整库同步_或指定数据表同步配置_04---大数据之Nifi工作笔记0056

查看>>

NIFI1.23.2_最新版_性能优化通用_技巧积累_使用NIFI表达式过滤表_随时更新---大数据之Nifi工作笔记0063

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_根据binlog实现数据实时delete同步_实际操作04---大数据之Nifi工作笔记0043

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_配置binlog_使用处理器抓取binlog数据_实际操作01---大数据之Nifi工作笔记0040

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_配置数据路由_实现数据插入数据到目标数据库_实际操作03---大数据之Nifi工作笔记0042

查看>>

NIFI从MySql中增量同步数据_通过Mysql的binlog功能_实时同步mysql数据_配置数据路由_生成插入Sql语句_实际操作02---大数据之Nifi工作笔记0041

查看>>

NIFI从MySql中离线读取数据再导入到MySql中_03_来吧用NIFI实现_数据分页获取功能---大数据之Nifi工作笔记0038

查看>>

NIFI从MySql中离线读取数据再导入到MySql中_不带分页处理_01_QueryDatabaseTable获取数据_原0036---大数据之Nifi工作笔记0064

查看>>

NIFI从MySql中离线读取数据再导入到MySql中_无分页功能_02_转换数据_分割数据_提取JSON数据_替换拼接SQL_添加分页---大数据之Nifi工作笔记0037

查看>>

NIFI从PostGresql中离线读取数据再导入到MySql中_带有数据分页获取功能_不带分页不能用_NIFI资料太少了---大数据之Nifi工作笔记0039

查看>>